Robots.txt est un fichier qui indique aux moteurs de recherche quelles zones de votre site web ils peuvent indexer. Quel est son rôle exact ? Comment le créer et comment l’utiliser pour votre référencement ?

Qu’est-ce que le fichier robots.txt ?

Le robots.txt est un fichier texte placé à la racine de votre site web. Ce fichier est destiné à interdire aux robots des moteurs de recherche l’indexation de certaines zones de votre site internet. Le fichier robots.txt est l’un des premiers fichiers analysés par les spiders (robots).

A quoi sert-il ?

Le fichier robots.txt donne des instructions aux robots des moteurs de recherche qui analyse votre site web, c’est un protocole d’exclusion des robots. Grâce à ce fichier, vous pouvez interdire l’exploration et l’indexation de :

- votre site à certains robots(également appelés « agents » ou « spiders« ),

- certaines pages de votre site aux robots et / ou de quelques pages à certains robots.

Pour bien comprendre l’intérêt du fichier robots.txt, nous pouvons prendre l’exemple d’un site composé d’une zone visible et publique pour communiquer auprès des clients et d’un intranet réservé aux salariés. Dans ce cas, la zone publique doit être accessible aux robots et la zone qui doit rester privée doit être interdite d’accès.

Ce fichier permet également d’indiquer aux moteurs l’adresse du fichier sitemap du site web.

Une balise Meta nommée « robots » placée dans le code html d’une page web peut également interdire son indexation avec la syntaxe suivante :.

Où trouver le fichier ROBOTS TXT ?

Le fichier robots.txt doit se trouver au niveau de la racine de votre site internet. Si vous souhaitez vérifier qu’il est bien présent sur votre site, vous devez taper dans la barre d’adresse de votre navigateur : http://www.adressedevotresite.com/robots.txt.

Si le fichier est :

- présent, il s’affichera et les robots suivront les instructions présentes dans le fichier.

- absent, une erreur 404 s’affichera et les robots considérons qu’aucun contenu n’est interdit.

Un site internet contient un seul fichier pour les robots et son nom doit être exact et en minuscule (robots.txt).

Comment créer un fichier robots.txt ?

Pour créer votre fichier robots.txt, vous devez pouvoir accéder à la racine de votre domaine.

Le fichier robots TXT peut être créé manuellement ou généré par défaut par la majorité des CMS comme WordPress au moment de leur installation. Il est également possible de créer votre fichier pour les robots sur des outils en ligne.

Pour le créer manuellement, vous pouvez utiliser un simple éditeur de texte tel que Notepad tout en respectant à fois :

- une syntaxe et des instructions,

- un nom de fichier : robots.txt,

- une structure : une instruction par ligne et aucune ligne vide.

Pour accéder au dossier de la racine de votre site web, vous devez posséder au minimum un accès FTP. Si vous ne disposez pas de cet accès, vous ne pourrez pas le créer et vous devrez prendre contact avec votre hébergeur ou votre agence web.

La syntaxe et les instructions du fichier robots.txt

Les fichiers robots.txt utilisent les instructions ou commandes suivantes :

- User-agent : les user-agents sont les robots des moteurs de recherche, par exemple Googlebot pour Google ou Bingbot pour Bing.

- Disallow : disallow est l’instruction qui interdit aux user-agents l’accès à une url ou à un dossier.

- Allow : allow est une instruction qui autorise aux user-agents l’accès à une url placée dans un dossier interdit.

Exemple de fichier robots.txt :

# fichier pour les robots du site http://www.adressedevotresite.com/

User-Agent: *(autorise l’accès à tous les robots )

Disallow: /intranet/(interdit l’exploration du dossier intranet)

Disallow: /login.php (interdit l’exploration de l’url http://www.adressedevotresite.com/login.php)

Allow: /*.css?*(autorise l’accès à toutes les ressources css)

Sitemap: http://www.adressedevotresite.com/sitemap_index.xml(lien vers le sitemap pour le référencement)

Dans l’exemple ci-dessus, la commande User-agent s’applique à tous les robots d’exploration grâce à l’insertion d’un astérisque (*). Le dièse (#) est utilisé pour afficher des commentaires, les commentaires ne sont pas pris en compte par les robots.

Vous trouverez sur le site http://robots-txt.com/ les ressources spécifiques à certains moteurs de recherche et certains CMS.

Le robots.txt et le SEO

Au niveau de l’optimisation du SEO de votre site internet, le fichier robots.txt permet :

- d’éviter les robots d’indexer des contenus dupliqués,

- de fournir le sitemap aux robots pour fournir des indications sur les URLs à indexer.

Comment tester votre fichier robots.txt ?

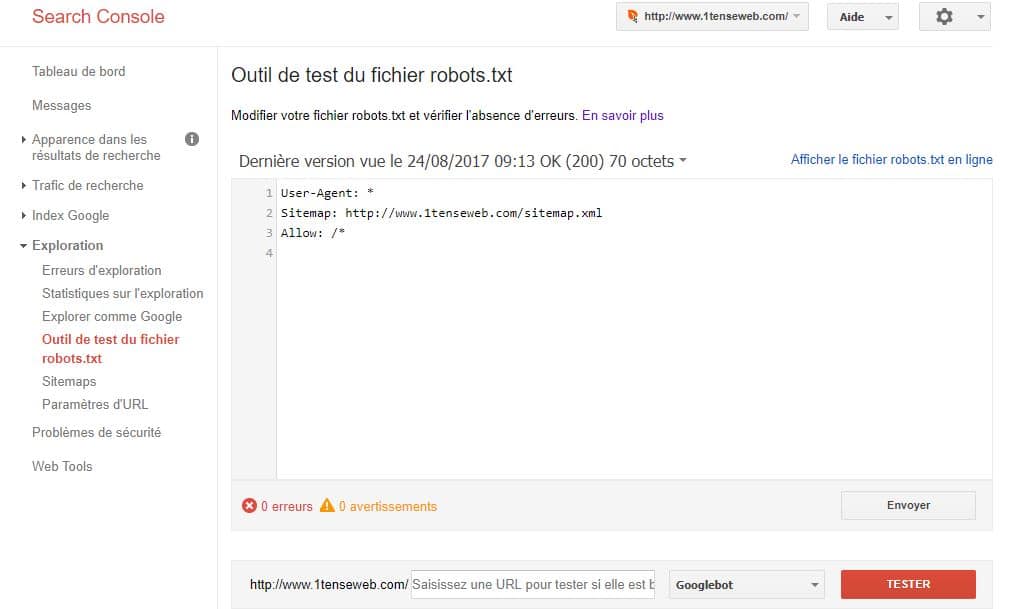

Pour tester votre fichier robots.txt, il vous suffit de créer et d’authentifier votre site sur Google Search Console. Une fois votre compte créé, vous devrez cliquer dans le menu sur Exploration puis sur Outil de test du fichier robots.txt.

Le test du fichier robots.txt permet de vérifier que toutes les URLs importantes peuvent être indexées par Google.

Pour conclure, si vous souhaitez avoir la maîtrise de l’indexation de votre site internet, la création d’un fichier robots.txt est indispensable. Si aucun fichier n’est présent, toutes les urls trouvés par les robots seront indexées et se retrouverons dans les moteurs de recherche.

L’article vous a plu??? Profitez de notre expertise en SEO, sur www.deelynx.com ou à l’agence digitale Deelynx basée à Douala au Cameroun.

Laissez un Commentaire